Разработан новый механизм самообучения ИИ

Искусственный интеллект развивается невероятными темпами и, кажется, вот-вот догонит живой — но есть колоссальное препятствие, которое мешает ему это сделать.

Люди умеют и любят усваивать новые знания, а большие языковые модели (LLM) не способны на это в полной мере. После развертывания полностью обученной модели ее «мозг» становится статичным и не может постоянно адаптироваться к новой информации. Иными словами, если пользователь сообщит LLM что-то важное, в следующем сеансе она об этом не вспомнит.

В Массачусетском технологическом институте (MIT) разработали процедуру самообучения LLM, превращающую ее в студента: она не просто механически сохраняет данные, а перерабатывает их в знания.

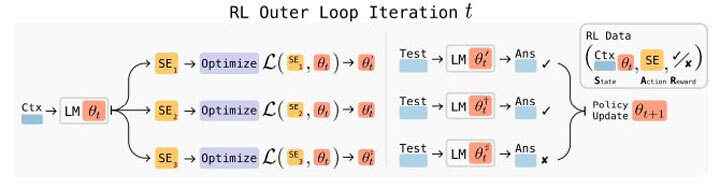

Модель создает несколько вариантов самоисправлений для обучения на основе входных данных и применяет каждый из них, чтобы определить, какой именно наиболее улучшает ее работу. Этот процесс проб и ошибок делает самообучение оптимальным. Такой подход повышает точность LLM в ответах на вопросы и распознавании образов, а также позволил небольшой модели превзойти значительно более крупные аналоги.

«Так же, как и люди, сложные системы ИИ не могут оставаться статичными на протяжении всего своего жизненного цикла. Ведь они работают не в статичной среде, а постоянно сталкиваются с новыми данными от пользователей. Мы хотим создать модель, которая была бы чуть более человечной — такую, которая могла бы непрерывно самосовершенствоваться», — говорит аспирант MIT Джотиш Пари, соавтор исследования, которое будет представлено на Конференции по системам обработки нейронной информации.

Научить модель учиться

LLM — это модели нейронных сетей, содержащие миллиарды параметров, называемых весами, которые хранят знания модели и обрабатывают входные данные для формирования прогнозов. Во время обучения модель меняет эти веса, а после развертывания они фиксируются.

Тем не менее, LLM неплохо справляются с так называемым обучением в контексте, когда модель осваивает новую задачу, увидев несколько примеров. Эти примеры направляют ответы модели, но полученные знания не сохраняются за пределами сеанса. Исследователи задались целью научить ИИ самостоятельно обновлять веса.

Разработанная ими система SEAL (self-adapting LLM) позволяет LLM генерировать новые синтетические данные на основе входных сведений и определять оптимальный способ адаптации и обучения; каждый фрагмент синтетических данных представляет собой самоисправление, которое модель может применить.

В случае с языком LLM создает синтетические данные, переформулируя информацию и ее следствия из входного текста. Это похоже на то, как студенты ведут конспекты лекций, записывая и обобщая материал.

Модель делает это несколько раз, а затем проводит самопроверку по каждому из самоисправлений, чтобы определить, какое из них привело к наибольшему росту производительности в последующей задаче. Для этого используется метод проб и ошибок, известный как обучение с подкреплением, где модель получает «вознаграждение» за наибольшее улучшение результата. Затем LLM запоминает лучший учебный материал, обновляя свои веса, чтобы усвоить информацию из этого самоисправления.

«Мы надеемся, что модель научится создавать наилучший вид конспекта — оптимальной длины и с должным разнообразием информации — такой, чтобы обновление модели на его основе приводило к улучшенному результату», — объясняет студент MIT Адам Цвайгер, соавтор работы.

Выбор оптимального метода

SEAL позволяет модели выбирать способ усвоения информации. То есть LLM сама отбирает нужные синтетические данные, определяет темп обучения и количество циклов тренировки.

«Люди знают, как им лучше всего учиться. Мы хотим предоставить такую же возможность LLM. Наделяя модель способностью управлять тем, как она перерабатывает информацию, мы даем ей свободу определять наилучший способ анализа всех поступающих данных», — говорит Пари.

SEAL превзошла несколько базовых методов в ряде задач, включая освоение нового навыка на основе примеров и усвоение знаний из текстового отрывка. В ответах на вопросы самообучаемость улучшила точность модели почти на 15%, а в некоторых задачах освоения навыков повысила процент успешного выполнения более чем на 50%.

Одним из ограничений этого подхода стала проблема катастрофического забывания: по мере неоднократной адаптации к новой информации производительность модели на ранее освоенных задачах постепенно снижается. Исследователи планируют смягчить этот эффект в следующих версиях своего продукта. Они также намерены применить эту методику в среде с множеством агентов, где несколько LLM будут обучать друг друга.

«Полностью развернутые самоадаптирующиеся модели — пока дело далекого будущего, но мы надеемся, что системы, которые умеют учиться, в конечном итоге придут к этому», — заключил Цвайгер.