Ученые заглянули в недра искусственного интеллекта

Нет сомнений, что технологии искусственного интеллекта сегодня доминируют в мире. Прогресс движется семимильными шагами, особенно в области больших языковых моделей (LLM), таких как ChatGPT.

Но как они работают? LLM состоят из нейронных сетей, обрабатывающих длинные последовательности токенов. Каждый токен — это обычно слово или часть слова, представленные списком из сотен или тысяч чисел — ученые называют его «многомерным вектором». Этот список отражает значение слова и его использование.

Например, слово «кошка» может превратиться в список вида [0.15, -0.22, 0.47, …, 0.09], а «собака» кодируется похожим образом, но с другими числами. Слова со схожим значением получают похожие списки, поэтому модель понимает, что «кошка» и «собака» ближе друг к другу, чем «кошка» и «банан».

Черный ящик даже для специалистов

Обработка языка как последовательности таких векторов весьма эффективна — но, как ни парадоксально, мы до конца не знаем, почему. Простые математические модели для длинных последовательностей многомерных токенов все еще толком не изучены.

Это создает пробел в нашем понимании: почему такой подход работает так хорошо и чем он принципиально отличается от старых методов? Почему лучше подавать данные в нейросети в виде последовательностей многомерных токенов, а не одного длинного списка чисел? Хотя современный ИИ умеет писать истории или отвечать на вопросы, внутренние механизмы, делающие это возможным, остаются «черным ящиком» — даже для специалистов.

Команда ученых под руководством Ленки Здеборовой из Федеральной политехнической школы Лозанны построила максимально простую математическую модель, которая при этом сохраняет суть обучения на токенах, как в LLM. Модель, названная билинейной последовательной регрессией (BSR), описана в журнале Physical Review X. Она упрощает реальный ИИ, но сохраняет его ключевую структуру, играя роль «теоретической площадки» для исследования процессов обучения нейросетей.

Как работает BSR

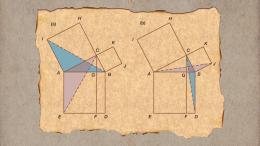

Представьте предложение, где каждое слово можно превратить в список чисел, отражающих его значение — как в LLM. Эти списки выстраиваются в таблицу, где каждая строка соответствует слову. Таблица сохраняет всю последовательность и детали каждого слова.

Четкий математический ориентир

В отличие от старых моделей ИИ, которые обрабатывали всю информацию сразу, BSR анализирует строки таблицы в одном направлении, а столбцы — в другом. Затем эти данные используются для предсказания результата — например, эмоциональной окраски предложения.

Сила BSR в том, что она достаточно проста для полного математического анализа. Это позволяет исследователям точно понять, когда обучение на последовательностях начинает работать и сколько данных нужно модели для надежного распознавания паттернов.

Кроме того, благодаря BSR становится ясно, почему использование последовательностей векторов дает лучшие результаты, чем «разворачивание» всех данных в один большой вектор. Модель выявила четкие пороги, после которых обучение переходит от бесполезного к эффективному, как только система «увидит» достаточное количество примеров.

Это исследование дает новый взгляд на внутреннюю работу больших языковых моделей. Точное решение BSR дает ясный математический ориентир, приближая нас к теории, которая сможет направлять разработку будущих систем ИИ. Эти идеи помогут ученым создавать более простые, эффективные — и, возможно, более прозрачные модели.